シンプル。

高速。

スケーラブル。

統合。

高速。

スケーラブル。

統合。

主な機能

バッチ/ストリーミングデータ

Python、SQL、Scala、Java、Rなど、お好みの言語を使用して、バッチ処理とリアルタイムストリーミング処理を統合します。

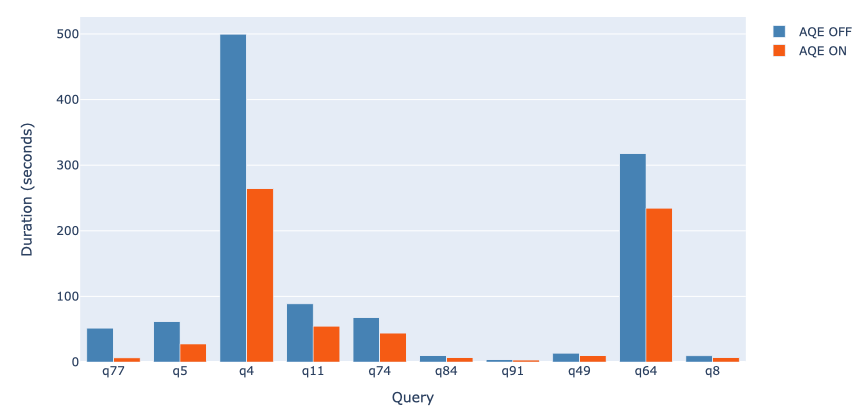

SQL分析

ダッシュボードやアドホックレポート作成のために、高速で分散されたANSI SQLクエリを実行します。ほとんどのデータウェアハウスよりも高速に動作します。

大規模データサイエンス

ダウンサンプリングに頼ることなく、ペタバイト規模のデータに対して探索的データ分析(EDA)を実行します。

機械学習

ラップトップで機械学習アルゴリズムをトレーニングし、同じコードを使用して、数千台のマシンの耐障害性クラスタにスケールアップします。